AIに「学習させる」とは、データをもとにパターンや規則を見つけ出し、予測や判断を可能にするプロセスを意味します。

近年はGoogle Colabやクラウドサービス、Pythonライブラリの進化によって、初心者でも比較的手軽にAIを学習させられる環境が整いました。

しかし実際には、どんな手順で学習させるのか?必要なデータやツールは何か? といった疑問を抱く方も多いのではないでしょうか。

本記事では、AIに学習させる方法を 基本の流れ → 実際の例 → 精度を高める工夫 → ビジネス導入時の注意点 の順に整理し、初心者にもわかりやすく解説します。

さらに、社内データを学習させる際に欠かせないリテラシー教育の重要性についても触れます。

AIを自ら学習させることは、業務効率化や新しい価値創出の第一歩です。ぜひ最後までご覧ください。

「必須ノウハウ3選」を無料公開

- 【戦略】AI活用を成功へ導く戦略的アプローチ

- 【失敗回避】業務活用での落とし穴6パターン

- 【現場】正しいプロンプトの考え方

AI学習とは何か?「学習させる」意味を整理

「AIに学習させる」とは、コンピュータに大量のデータを与え、その中からパターンやルールを抽出させるプロセスを指します。

これにより、AIは新しいデータに対しても予測や判断を行えるようになります。

AI・機械学習・ディープラーニングの関係

- AI(人工知能):人間の知的活動をコンピュータで再現する広い概念

- 機械学習:AIを実現するための技術のひとつ。データから規則を学ぶ手法

- ディープラーニング:機械学習の中でもニューラルネットワークを使った高度な学習手法

「AIに学習させる」というのは、厳密には機械学習・ディープラーニングによるモデル訓練を指すことが多いです。

なぜ「学習」と呼ぶのか(人間の学習との違い)

人間の学習は「経験を積んで知識や技能を得る」ことですが、AIの学習は データを通じて数値的なパターンを獲得する ことを意味します。

- 人間:失敗や成功を反復し、意味や文脈も含めて理解

- AI:膨大なデータを処理し、入力と出力の関係を統計的に最適化

人間は「意味を理解」しますが、AIは「パターンを最適化」する点が大きな違いです。

AIに学習させることで何が可能になるのか(分類・予測・生成)

AI学習を行うことで、さまざまな領域での活用が可能になります。

- 分類:メールが迷惑メールか否かを判別

- 予測:売上や需要を予測

- 生成:テキストや画像を自動生成

このように「学習=データから知識を得る仕組み」を持たせることで、AIは単なる計算機から「応用可能な意思決定ツール」へと変わります。

AI学習の仕組みや種類をもっと詳しく知りたい方は、こちらの記事で解説しています。

AIに学習させる前に準備すべきこと

AI学習を成功させるには、ただデータを用意して学習を回すだけでは不十分です。

目的・データ・環境の3点を準備することで、効率的かつ効果的に学習を進められます。

目的の明確化(分類?予測?生成?)

まず取り組む前に、AIに何をさせたいのかを明確にしましょう。

- 分類タスク:例)スパムメール判定、画像のカテゴリ分け

- 予測タスク:例)売上予測、需要予測、在庫管理

- 生成タスク:例)文章生成、画像生成、要約作成

ゴールが定まれば、必要なデータやモデルの選択肢も明確になり、無駄な作業を避けられます。

データ収集と前処理(クレンジング・正規化・ラベル付け)

AIはデータの質に大きく左右されます。

「Garbage in, Garbage out(不良データを入れれば、不良結果が出る)」の原則に従い、前処理を徹底しましょう。

- クレンジング:欠損値の処理、重複の削除、誤入力の修正

- 正規化:数値のスケールを揃える(例:0〜1に変換)

- ラベル付け:分類タスクでは正解データを付与する(例:犬/猫の画像にラベルをつける)

多くの失敗は「データの質」が原因です。ここに時間をかけることが、後の精度向上につながります。

学習環境の準備(Python, Jupyter Notebook, Google Colab, クラウドAIサービス)

次に、学習を実行するための環境を整えます。

- Python & ライブラリ:scikit-learn、TensorFlow、PyTorchなどが定番

- Jupyter Notebook:コード・実行結果・メモを一元管理できる便利な開発環境

- Google Colab:無料でGPUが使えるクラウド環境。初心者に最適

- クラウドAIサービス:AWS SageMaker、GCP Vertex AI、Azure MLなど。大規模学習や業務導入に適する

最初は Colabやローカル環境で小さく始め、ビジネスで本格活用する段階になったら クラウドAI基盤へ移行するのが効率的です。

AIに学習させる基本的な手順

AI学習の流れは大きく分けて 「データ準備 → モデル選択 → 学習 → 評価 → 改善」 のサイクルです。

このサイクルを繰り返すことで、AIは精度を高めていきます。

① データ分割(学習用・検証用・テスト用)

まずはデータを3種類に分けます。

- 学習用データ:AIが規則やパターンを学ぶために使う

- 検証用データ:学習途中で精度を確認し、モデルを調整するために使う

- テスト用データ:最終的な実力を測るために使う

この分割を怠ると「過学習(学習データには強いが新規データに弱い)」が起こりやすくなります。

② モデルの選択(scikit-learn / TensorFlow / PyTorch)

次に、タスクに応じたモデルとライブラリを選びます。

- scikit-learn:軽量で扱いやすく、分類や回帰タスクに最適

- TensorFlow:Google製。大規模学習や深層学習に強い

- PyTorch:研究用途や開発スピードを重視する場合に人気

どのライブラリもPythonで利用可能。初心者はscikit-learnから始め、応用でTensorFlowやPyTorchに進むのがおすすめです。

③ 学習の実行(トレーニング)

モデルに学習用データを与えて、パターンを見つける作業=トレーニングを行います。

- 分類なら「この特徴があれば犬、この特徴なら猫」と学ぶ

- 回帰なら「売上は広告費が増えると増える」と傾向を掴む

- ニューラルネットワークでは、重み(パラメータ)を最適化していく

学習は「試行錯誤を高速で繰り返す」イメージです。

④ 精度評価(正解率・再現率・F1スコア)

学習が終わったら、検証用データを使ってモデルの性能を測ります。

- 正解率(Accuracy):全体のうち正しく予測できた割合

- 再現率(Recall):本来「正」とすべきデータをどれだけ正しく当てられたか

- F1スコア:正解率と再現率のバランスを取った指標

単一指標ではなく、複数を見て総合的に判断するのが重要です。

⑤ 改善と再学習(ハイパーパラメータ調整・過学習対策)

評価の結果をもとに、再度モデルを改善します。

- ハイパーパラメータ調整:学習率、層の数、木の深さなどを調整

- 過学習対策:正則化、ドロップアウト、データ拡張で汎用性を高める

- 再学習:改善案を取り入れて、もう一度学習サイクルを回す

成功しているAIプロジェクトは「一度で終わらず、改善サイクルを仕組み化」しています。

実際にAIを学習させる例

AI学習の流れを理解したら、実際に小さなデータで試してみるのが効果的です。

ここでは初心者でも取り組みやすい「画像分類」と「テキスト分類」の例を紹介し、最後にPythonコードで体験できるシンプルな学習サンプルを提示します。

画像分類(MNIST手書き数字の判別)

最も有名な学習用データセットが MNIST(手書き数字データセット) です。

0〜9までの白黒画像を70,000枚収録しており、AIに「数字を正しく認識できるか」を学習させます。

- 学習データ:60,000枚の画像

- テストデータ:10,000枚の画像

- 目的:画像の特徴を学び、新しい数字を正しく分類する

画像認識の基礎を学ぶのに最適なタスクです。

テキスト分類(スパムメール判定)

もう一つ身近な例が、メールのスパム判定です。

過去のメールを「スパム」か「通常メール」にラベル付けし、そのデータを使って学習します。

- 入力:メール本文の単語・特徴量

- 出力:「スパム」 or 「通常」

- 実用例:迷惑メールフィルタ、SNSの不適切投稿検出

ビジネス活用の代表例で、テキストデータを扱うAIの第一歩となります。

Pythonコード例で学習の流れを体験

以下は、scikit-learnを使ったシンプルな分類モデルのサンプルです。

(例:手書き数字データを読み込み、学習 → 予測まで実行)

| from sklearn.datasets import load_digitsfrom sklearn.model_selection import train_test_splitfrom sklearn.linear_model import LogisticRegressionfrom sklearn.metrics import accuracy_score # データ読み込み(手書き数字)digits = load_digits()X, y = digits.data, digits.target # 学習用とテスト用に分割X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # ロジスティック回帰モデルを学習model = LogisticRegression(max_iter=10000)model.fit(X_train, y_train) # テストデータで精度を評価y_pred = model.predict(X_test)print(“正解率:”, accuracy_score(y_test, y_pred)) |

20行程度のコードで「学習 → 予測 → 精度評価」まで体験可能です。

「実際に試してみたけれど、自社のデータを学習させたい方はこちら」

学習効率・精度を高める工夫

AI学習は「学習させれば終わり」ではなく、精度を高める工夫を繰り返すことが成功の鍵です。

ここでは代表的な改善手法と、近年注目される最新の学習アプローチを紹介します。

データ拡張・特徴量エンジニアリング

AIの精度を高める最も基本的な方法が、データの工夫です。

- データ拡張(Data Augmentation)

→ 画像を回転・反転・色調変更してデータ量を増やす

→ テキストなら言い換えや不要語の削除など

→ 少ないデータでも学習の汎用性を高められる - 特徴量エンジニアリング

→ データから意味のある指標を作ること

→ 例:購買履歴から「購入頻度」「平均購入金額」などを抽出

→ データが持つ潜在的な力を引き出し、予測精度を大きく改善

「質 × 量」を両立させる工夫が、モデル改善の出発点です。

転移学習(既存モデルの再利用)

一からAIを学習させるのは膨大なデータと計算資源を必要とします。

そこで使えるのが 転移学習(Transfer Learning) です。

- すでに学習済みのモデルを再利用し、自分の目的に合わせて微調整

- 例:画像認識モデル「ResNet」をベースに、自社の製品画像分類に応用

- 少ないデータでも高精度を実現でき、開発コストも削減可能

ビジネス現場では「ゼロから学習」よりも「転移学習」が主流になりつつあります。

自己教師あり学習や少数データ学習の最新動向

近年注目されるのが、データ不足を克服するための新しい学習法です。

- 自己教師あり学習(Self-Supervised Learning)

→ 正解ラベルを用意しなくても、自動で擬似タスクを作って学習

→ 例:テキストの穴埋め(言語モデルBERTなど)

→ ラベル付けコストを削減できる - 少数データ学習(Few-Shot / Zero-Shot Learning)

→ ごく少ないデータ、あるいは未学習のカテゴリでも推論可能

→ ChatGPTや大規模言語モデル(LLM)が実現しているアプローチ

これらの最新手法はまだ発展途上ですが、少ないデータで効果を出したい企業にとって有力な選択肢です。

ビジネス現場でAIを学習させる際の注意点

AIをビジネスに導入する際は、単にモデルを動かすだけでは成功しません。

データ不足・コスト・セキュリティ・社内リテラシーといった実務的な課題にどう対応するかが重要です。

データ不足問題と外部データ活用

企業内データだけでは学習に十分な量や多様性が確保できないケースがあります。

その場合は以下の工夫が有効です。

- 外部データの活用:オープンデータや業界標準データセットを利用

- データ拡張:既存データを加工して学習データ量を増やす

- 転移学習:学習済みモデルをベースに自社データで微調整

「データが足りないからAI導入は無理」と結論づけるのは早計です。工夫次第で少ないデータからでも活用可能です。

クラウドサービスとコスト管理(AWS, GCP, Azure)

AI学習には膨大な計算資源が必要ですが、オンプレミス環境を構築すると初期投資が大きくなります。

そのため、多くの企業は クラウドAIサービス を活用しています。

- AWS SageMaker:開発から運用まで一貫サポート

- GCP Vertex AI:Googleの強みであるデータ分析と統合しやすい

- Azure Machine Learning:Microsoft製品との親和性が高い

ただしクラウドは使った分だけ課金されるため、コスト管理とスケーリング戦略が欠かせません。

セキュリティと機密情報流出リスク

AI学習で最大の懸念の一つが 社内データや顧客情報の流出 です。

- 外部サービスにアップロードする場合 → 契約内容を確認し、学習利用の有無を把握する

- モデルのブラックボックス化 → 予測根拠が説明できないリスク

- プライバシー保護 → 匿名化やマスキング処理で個人情報を守る

「精度」と同じくらい「安全性」にも配慮することが求められます。

社内導入の壁(リテラシー不足・抵抗感)

技術的に学習モデルを構築できても、社内の理解と教育が不足していると導入は進みません。

- 「AIは難しい」「自分の仕事が奪われる」という抵抗感

- 部署ごとにデータが分断され、活用が進まない

- 導入担当者の知識不足により、運用が形骸化する

技術だけでなく、教育・ルール・文化を整えることが成功のカギです。

「AIを業務に活かすには、技術だけでなく教育と体制づくりが必要です」

よくあるつまずきと解決策

AIに学習をさせると、初心者でも必ずといってよいほど「壁」にぶつかります。

ここでは代表的なつまずきと、その解決策を整理しました。

エラーで学習が止まる → データ形式の確認

- CSVや画像などの入力データの形式が揃っていないとエラーが出やすい

- 欠損値や異常値が含まれている場合も処理が止まる原因に

- 解決策:学習前にデータをクリーニングし、形式を統一する

「まずデータを疑う」のが鉄則です。

精度が上がらない → データ量・特徴量を見直す

- データが少なすぎる、あるいは偏っていると精度が上がらない

- 入力に使っている特徴量がタスクに合っていない可能性も

- 解決策:データを追加収集、または特徴量エンジニアリングで新しい指標を作成

単に「学習回数を増やす」だけでは改善できません。

過学習になる → 正則化・ドロップアウトを使う

- 学習データでは高精度だが、新しいデータでは性能が落ちる状態

- 原因:学習データに「覚え込みすぎて」汎用性を失っている

- 解決策:

- L1/L2正則化でモデルをシンプルに保つ

- ニューラルネットワークではドロップアウトを導入

- データ拡張で多様性を持たせる

過学習対策は「モデルを賢くしすぎない工夫」です。

学習が遅い → GPUやクラウドの活用

- ノートPC環境では計算速度が遅く、学習に数時間〜数日かかることも

- 解決策:

- GPU対応PCを利用

- Google ColabやAWS SageMaker、GCP Vertex AIなどクラウドを活用

- バッチサイズや学習回数を調整し効率化

「環境を変える」ことも立派な解決策です。

まとめ|AIに学習させる第一歩は「小さく試す」ことから

AI学習の流れは、

仕組みの理解 → 準備 → 手順 → 実際の事例 → 導入時の注意点

というサイクルで整理できます。

本記事で紹介したように、AIにデータを学習させるプロセスは決して特別なものではなく、適切な準備と工夫で誰でも取り組める時代になっています。

強調したいのは、

「AI学習は難しそうに見えても、環境が整っている今こそ誰でも始められる」

ということです。

最初はColabや公開データセットを使った小さな実験から始め、成果を感じたら徐々に社内データやクラウドサービスへ拡張していきましょう。

ただし、本格導入には 技術だけでなく教育や組織体制の整備 が欠かせません。

- QAIに学習させるにはどのくらいのデータが必要ですか?

- A

タスクの種類によって必要なデータ量は異なります。

シンプルな分類なら数千件でも可能ですが、精度を重視する場合や複雑なタスク(画像生成・自然言語処理など)では数十万件以上が必要になることもあります。

データが少ない場合は、転移学習やデータ拡張を活用すると有効です。

- Q初心者がAI学習を試すには何から始めればいいですか?

- A

まずはGoogle Colabを利用して、公開データセット(例:手書き数字MNIST)を使った学習を体験するのがおすすめです。

環境構築の負担がなく、20行程度のコードで「学習 → 評価」まで実行できます。

- QAI学習に必要なプログラミング言語は?

- A

最も一般的なのは Python です。

scikit-learnやTensorFlow、PyTorchなど、主要なライブラリが揃っており、学習に最適です。

RやJuliaなどもありますが、ビジネス利用や実務ではPythonが標準となっています。

- Q自社の業務データをAIに学習させても大丈夫ですか?

- A

活用可能ですが、セキュリティや契約条件には注意が必要です。

外部クラウドにアップロードする場合は「そのデータが再利用されないか」「学習に使われる可能性がないか」を必ず確認しましょう。

機密性の高いデータは、匿名化やオンプレミス環境での利用が推奨されます。

- QAIを学習させても精度が出ないのはなぜですか?

- A

原因として多いのは、

- データ量や質が不十分

- 特徴量設計が不適切

- モデルがタスクに合っていない

などです。

データ拡張や転移学習、ハイパーパラメータ調整を組み合わせると改善できるケースが多いです。

- QAI学習の費用はどれくらいかかりますか?

- A

小規模な学習ならGoogle Colabなど無料サービスで始められます。

ビジネス利用や大規模学習ではクラウドAIサービス(AWS SageMaker、GCP Vertex AI、Azure MLなど)を利用し、数万円〜数十万円単位のコストが発生する場合もあります。

予算に応じて 「小さく始めて大きく育てる」 のが基本です。

法人向け支援サービス

「生成AIを導入したけど、現場が活用できていない」「ルールや教育体制が整っていない」

SHIFT AIでは、そんな課題に応える支援サービス「SHIFT AI for Biz」を展開しています。

AI顧問

活用に向けて、業務棚卸しやPoC設計などを柔軟に支援。社内にノウハウがない場合でも安心して進められます。

- AI導入戦略の伴走

- 業務棚卸し&ユースケースの整理

- ツール選定と使い方支援

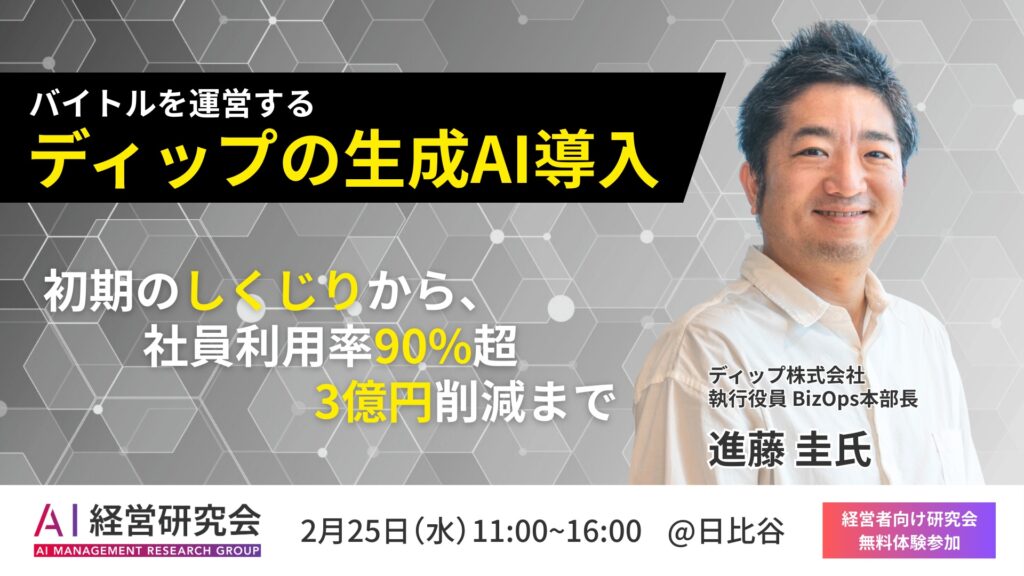

AI経営研究会

経営層・リーダー層が集うワークショップ型コミュニティ。AI経営の実践知を共有し、他社事例を学べます。

- テーマ別セミナー

- トップリーダー交流

- 経営層向け壁打ち支援

AI活用推進

現場で活かせる生成AI人材の育成に特化した研修パッケージ。eラーニングとワークショップで定着を支援します。

- 業務直結型ワーク

- eラーニング+集合研修

- カスタマイズ対応