生成AIの普及に伴い、「自分の作品やデータが勝手に学習に使われるのでは?」という不安が高まっています。

特にイラストや文章などの公開コンテンツは、AIモデルに取り込まれるリスクがあり、著作権やプライバシーの観点からも大きな課題です。

こうした問題への対策として注目されているのが、ノイズ付加や透かしなどの「AI学習防止技術」です。

本記事では、ノイズによる学習防止の仕組みや最新ツールの特徴、さらに企業や個人が実務で活用するためのポイントをわかりやすく解説します。

AI学習を防ぐ方法を理解することは、大切な知的財産を守る第一歩です。ぜひ最後までご覧ください。

「必須ノウハウ3選」を無料公開

- 【戦略】AI活用を成功へ導く戦略的アプローチ

- 【失敗回避】業務活用での落とし穴6パターン

- 【現場】正しいプロンプトの考え方

なぜ「AI学習の防止」が求められるのか

AIによる学習は便利さをもたらす一方で、著作権侵害や情報流出のリスクを含んでいます。

ここでは、学習防止が求められる背景を3つの観点から解説します。

生成AIによる無断学習のリスク(著作権・プライバシー)

イラストや写真、文章といったコンテンツが、権利者の許可なく学習に利用されるケースが問題視されています。

著作権がある作品をAIが取り込むと、二次利用や生成物の帰属をめぐるトラブルにつながります。

また、SNSやブログに公開した個人情報が学習されると、プライバシー侵害や想定外の情報拡散が起こりかねません。

これは個人だけでなく、企業ブランドの毀損リスクにも直結します。

企業データが流出するリスク(社内文書・顧客情報)

企業においては、AI活用の際に社内文書や顧客データが学習に利用されるリスクが懸念されます。

- 社内会議資料や契約書などの機密文書

- 顧客名簿や購買履歴などの個人データ

これらが生成AIサービスに入力され、そのまま学習に反映されれば、機密情報が外部に再利用される可能性があります。

情報漏洩は法的責任だけでなく、信頼失墜や競争力低下につながる重大リスクです。

法規制・社会的議論の背景(EU AI法・国内動向)

こうした懸念を受け、各国で規制やルールづくりが進められています。

- EU AI法:AIのリスクレベルを分類し、高リスク用途には厳格な規制を課す

- 国内動向:著作権法や個人情報保護法の適用可能性が議論され、学習データの扱いに注目が集まっている

社会全体で「どこまで学習を許すのか」「権利保護をどう担保するのか」という議論が進んでおり、企業やクリエイターにとっても無視できないテーマです。

AI学習の仕組みを基礎から理解したい方は、こちらの記事で詳しく解説しています。

AI学習を防止する代表的な手法

AIによる無断学習を防ぐには、技術的対策と利用上の工夫の両方が必要です。

ここでは比較的取り入れやすい代表的な手法を紹介します。

利用規約・設定によるオプトアウト(ChatGPTや画像生成AIの設定例)

一部の生成AIサービスでは、入力内容を学習に利用しない設定が用意されています。

例えば ChatGPT では「学習への利用をオフ」にでき、画像生成AIでも作品を学習データに含めない申請が可能です。

- メリット:導入コストが低く、即実行できる

- 限界:サービス提供者のポリシーに依存し、完全な保証は難しい

ポイント:業務利用時には利用規約やプライバシーポリシーを必ず確認することが重要です。

データの匿名化・マスキング

機密性の高いデータを扱う場合は、匿名化やマスキングによって学習に使われても個人や企業が特定されないようにする方法があります。

- 匿名化:氏名や住所を削除し、識別できない形にする

- マスキング:一部を置換(例:クレジット番号を「XXXX」で隠す)

これにより、万一AIが学習しても重大な漏洩リスクを避けられる点がメリットです。

ウォーターマーク(透かし)による保護

画像やイラストの場合は、透かし(ウォーターマーク)を重ねることで学習データとして利用されにくくできます。

- SNSに公開する作品にロゴや著作権表示を挿入

- 半透明のマークでコピー利用や不正学習を抑制

ただし、透かしは視覚的に目立つため、作品の見栄えやブランド性に影響する場合もあります。

そのため、後述する「ノイズ付加技術」との組み合わせが現実的な選択肢となります。

ノイズ付加による防止技術の仕組み

近年注目されているのが、ノイズを加えることでAIの学習を妨害する技術です。

見た目にはほとんど影響を与えず、AIにとってだけ「学びにくいデータ」に変換できるため、著作権保護や機密保持の手段として期待されています。

Glaze・Nightshadeなど代表的ツールの仕組み

- Glaze:シカゴ大学の研究チームが開発。イラストや画像に微細なノイズを加えることで、AIが作風を模倣できないようにする

- Nightshade:Glazeの進化版。AIに「誤った特徴」を学ばせることで、生成結果そのものを崩す

- 商用アプリへの実装:Clip StudioやibisPaintなど、一部のアプリでは簡単にノイズ付加できる機能が搭載され始めている

ポイント:専門知識がなくても、一般ユーザーが使える段階に近づいている

画像・テキストに見えないゆがみを与える原理

ノイズ付加は、人間の目では認識できないレベルの「微小なゆがみ」をデータに加える仕組みです。

- 画像:ピクセル単位で微妙な色・線の変化を加え、AIの特徴抽出を誤らせる

- テキスト:文法的には自然だがAIモデルにとって学習困難な単語置換・符号化を施す

この結果、AIは「正しい特徴」をつかめず、精度が著しく低下します。

メリット(学習阻害効果)と限界(ノイズ除去技術の進展)

メリット

- 作品やデータの価値を保ったまま、学習を防げる

- 公開物に自動適用できる仕組みが整えば、運用コストを抑えられる

限界

- ノイズを除去する技術も進化しており、「いたちごっこ」になっている

- 強すぎるノイズは見た目や可読性に影響する

- 現時点では100%の防御は困難

ポイント:「万能ではないが、現実的な選択肢の一つ」と理解することが重要

実験データから見る効果の比較(研究・Qiita事例を引用)

研究者や開発者による検証では、以下のような結果が報告されています。

- Qiita記事の調査:ランダムノイズや特定パターンノイズの種類によって学習精度が大きく低下

- Glaze実験:強度設定を変えると、AIの出力が「全く別のタッチ」に変化

- Nightshade検証:誤学習効果が強く、生成結果が破綻するケースも確認

実証データを交えることで、「効果は理論上ではなく実際に確認されている」と伝えられます。

最新のノイズ技術は理解できたけど、「自社でどの対策を導入すべきか悩む…」という方も多いはずです。

ビジネス現場での実務的な防止策

AI学習防止の仕組みを理解したら、次に重要なのは実務にどう落とし込むかです。

ここでは企業が取るべき具体的な対策を整理します。

社内ドキュメントやナレッジをAI学習から守る方法

業務で利用する資料やナレッジベースは、外部の生成AIに入力すると学習に使われる可能性があります。

防止のためには以下の施策が有効です。

- 社内専用の生成AI環境を利用(オンプレ/閉域クラウド)

- アクセス制御:機密文書をAIツールに入力しないルール化

- 加工・フィルタリング:公開前に個人情報や固有名詞を自動マスク

ポイント:技術的な対策に加えて、従業員教育によるルール徹底が不可欠です。

クラウドサービス利用時の契約・規約確認

生成AIサービスやクラウドを業務利用する際は、契約条件や利用規約を必ず確認しましょう。

- データ保持の有無:入力したデータが学習や二次利用に使われないか

- 保存期間:どのくらい保持されるか

- オプトアウト権:学習対象から除外できる仕組みがあるか

ポイント:ベンダー任せにせず、法務部門や情報システム部門と連携して確認する体制が必要です。

クリエイティブ企業での導入事例(ノイズ付加+権利保護)

デザイン・広告・ゲーム制作などクリエイティブ分野では、作品を守るためのノイズ付加や透かし導入が進んでいます。

- 公開作品にGlazeやウォーターマークを施す

- 社内フローに「ノイズ加工→公開」を組み込み、担当部署で一括処理

- 著作権表示や権利保護ポリシーと併用する事例も増加

ポイント:単発対応ではなく「制作フローに組み込む」ことが鍵。

リスクとコストを踏まえた選定基準(どの技術をいつ使うか)

防止技術は万能ではなく、コストやリスクとのバランスで選ぶ必要があります。

- ノイズ付加:高い防止効果。ただし見栄えや処理時間に影響

- 透かし:簡単で低コスト。ただし美観やブランド性に影響

- 規約によるオプトアウト:即効性あり。ただしベンダー依存で不安定

- 匿名化/マスキング:業務文書向け。データ分析精度が下がる場合も

ポイント:「守りたい資産の種類」×「許容できるコスト」を基準に選ぶことが合理的です。

AI学習防止を成功させるために必要な体制

AI学習防止は、技術を導入するだけでは不十分です。

「誰が」「どのように」運用するか、そして社員が正しく理解しているかが成果を大きく左右します。

運用フローの設計(誰が加工するのか、どの段階で適用するのか)

ノイズ付加や透かしの導入を効果的にするには、業務フローへの組み込みが必須です。

- クリエイティブ制作なら「公開前チェック」工程にノイズ付加を追加

- 文書管理なら「外部共有前」にマスキングや匿名化を自動適用

- 担当者の明確化:制作チーム・情報システム部門・法務部門のどこで処理するかを明確にする

ポイント:属人的な判断にせず、一貫したルール化を行うことが重要です。

社員教育・リテラシー強化の重要性

AI防止策を導入しても、利用者がルールを理解しなければ抜け漏れが発生します。

- 生成AIへの入力禁止情報をリスト化し、全社員に共有

- 定期的な研修で「何を守るべきか」を実務事例とともに伝える

- 現場での問い合わせに答える仕組みを設ける

ポイント:社員一人ひとりのリテラシー強化が、システム導入以上に大きな効果を持ちます。

成功企業の共通点は「技術+教育+ルール」の三本柱

AI学習防止を実現できている企業には共通点があります。

- 技術:ノイズ付加やオプトアウト設定などを導入

- 教育:社員研修でリテラシーを底上げ

- ルール:社内規定や運用フローを明文化し、実行可能な形で徹底

この三本柱を揃えることで、初めて「実効性のあるAI学習防止」が実現します。

社内でAI活用とリスク管理を両立させるには、まず教育から始めるのが近道です。

今後の動向と課題

AI学習防止の技術は日々進化していますが、同時に新しい課題も生まれています。

今後の展開を見据え、企業が備えるべき視点を整理します。

ノイズ除去技術との“いたちごっこ”

ノイズ付加は有効な防止策ですが、AIがノイズを無視したり除去したりする技術も進化しています。

- 研究段階では、フィルタリングによってノイズを消去できるケースも確認されている

- 学習側のモデルが強力になるほど、ノイズを突破して特徴を抽出する可能性が高まる

ポイント:ノイズだけに依存せず、複数の防止策を組み合わせる戦略が必要です。

法的整備・オプトアウト権の進展

社会的には「学習に使われない権利」を巡る議論が進んでいます。

- EU AI法:高リスクAIへの規制強化、著作権保護の枠組みが具体化

- 国内動向:文化庁や経産省を中心に、著作権の扱いやオプトアウト制度の検討が始まっている

- 業界団体の動き:クリエイター団体や出版社がガイドラインを発表

ポイント:法的整備が進む一方で、制度が整うまでの“過渡期”をどう守るかが課題になります。

企業が今後備えるべき対応(コンプライアンス・教育)

不確実な状況の中で、企業が取るべき方向性は明確です。

- コンプライアンス強化:利用規約・契約確認を徹底し、法改正に即応できる体制を持つ

- 技術と教育の併用:ノイズ付加や匿名化とあわせて、社員リテラシー研修を定期実施

- 長期視点での体制整備:AIリスク管理を情報セキュリティの一部として位置づける

ポイント:短期的な技術対策と、中長期的な教育・ルール整備を両立させることが重要です。

まとめ|AI学習防止は「技術+教育+ルール」で進める

本記事では、AI学習防止の必要性から具体的な手法、実務での導入、そして今後の動向まで整理しました。

- リスク:生成AIによる無断学習は著作権・プライバシー・機密保持の脅威

- 技術対策:オプトアウト、匿名化、透かし、そしてノイズ付加技術が有効

- 実務導入:社内文書やクリエイティブ制作フローに防止策を組み込み、契約・規約を確認する

- 教育:技術だけでなく、社員一人ひとりのリテラシー強化とルール徹底が成功の鍵

強調すべきは、「ノイズ付加は有効な手段だが、それだけで完璧ではない」という点です。

いたちごっこの側面があるからこそ、技術+教育+ルールの三本柱を揃えることが重要になります。

AIを安全に業務へ活用するには、防止技術とあわせて社内教育が欠かせません。

その第一歩をサポートする 【生成AI研修】の詳細資料 をぜひご覧ください。

法人向け支援サービス

「生成AIを導入したけど、現場が活用できていない」「ルールや教育体制が整っていない」

SHIFT AIでは、そんな課題に応える支援サービス「SHIFT AI for Biz」を展開しています。

AI顧問

活用に向けて、業務棚卸しやPoC設計などを柔軟に支援。社内にノウハウがない場合でも安心して進められます。

- AI導入戦略の伴走

- 業務棚卸し&ユースケースの整理

- ツール選定と使い方支援

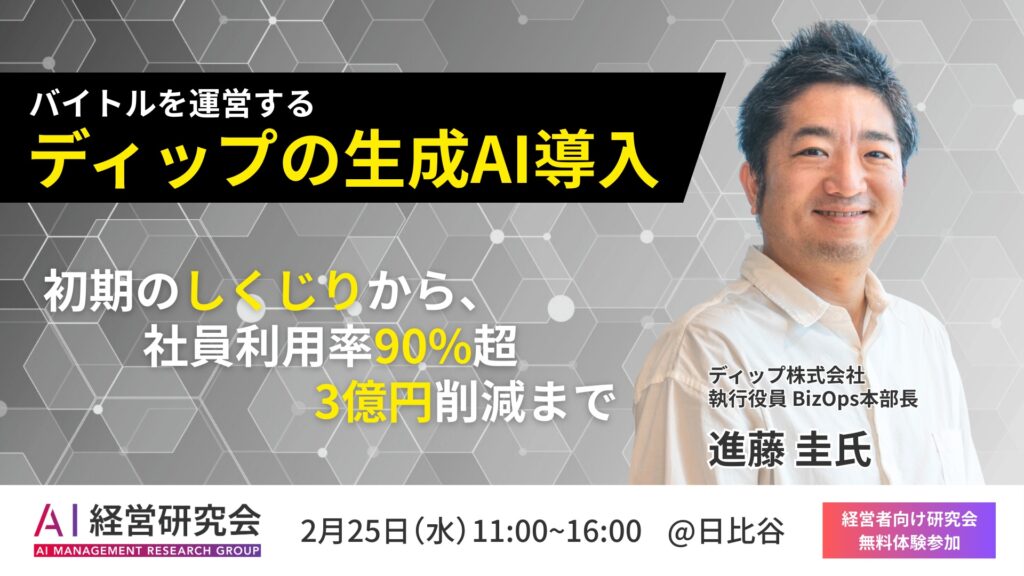

AI経営研究会

経営層・リーダー層が集うワークショップ型コミュニティ。AI経営の実践知を共有し、他社事例を学べます。

- テーマ別セミナー

- トップリーダー交流

- 経営層向け壁打ち支援

AI活用推進

現場で活かせる生成AI人材の育成に特化した研修パッケージ。eラーニングとワークショップで定着を支援します。

- 業務直結型ワーク

- eラーニング+集合研修

- カスタマイズ対応

- QAI学習防止のノイズは本当に効果がありますか?

- A

一定の効果は確認されています。GlazeやNightshadeなどのツールはAIの特徴抽出を妨害し、作風やデータ利用を阻止できます。ただし、ノイズ除去技術も進化しているため、万能ではなく他の対策と併用することが推奨されます。

- Qノイズを加えると作品やデータの見栄えは悪くなりますか?

- A

通常の閲覧では気づかれない程度のノイズが多いため、見た目への影響は限定的です。ただし、強度を上げすぎると画像や文章の品質が損なわれる場合があります。目的とバランスを見極めることが重要です。

- Q自社の社内データをAIに学習されないようにするにはどうすればいいですか?

- A

まずは利用規約や契約を確認し、オプトアウト設定が可能かを把握しましょう。加えて、外部公開前に匿名化やマスキングを行い、機密情報は生成AIに入力しないルールを徹底することが基本です。

- Qウォーターマーク(透かし)とノイズ付加はどちらが有効ですか?

- A

ウォーターマークは視覚的にコピー利用を抑制するのに有効ですが、AI学習を完全に防げるわけではありません。ノイズ付加はAIへの影響を直接与える点で強力ですが、除去技術との競争も進んでいます。両者を組み合わせるのが現実的です。

- Q企業で導入する際の課題は何ですか?

- A

主な課題は「コスト」「運用体制」「社員のリテラシー」です。ノイズ付加ツールや匿名化処理には時間とコストがかかり、誰が担当するかを明確にしなければ形骸化します。教育とルール整備を並行することが成功の鍵です。